"추론도 가능하다"..AI 연구 새 이정표 썼다

(지디넷코리아=손경호 기자)지금까지 인공지능(AI) 기술의 한 분야인 딥러닝은 주어진 이미지나 음성을 인식하거나 문장을 다른 언어로 번역하는 등 작업에서 눈에 띄는 성과를 거둬왔다.

그러나 여전히 인간처럼 여러가지 상황을 종합적으로 판단해 다음 상황을 예측하는 수준의 지능을 갖는데 도달하지는 못했다.

지난 5일(현지시간) 구글 자회사 딥마인드 연구팀은 미국 코넬대 아카이브(arXiv.org)에 두 가지 논문을 새로 게재하면서 AI가 인간처럼 관계형 추론까지 할 수 있다는 사실을 증명했다.

연구팀은 '관계형 추론을 위한 단순한 인공신경망(A simple neural network module for relational reasoning)'이라는 논문에서 관계형 네트워크(Relation Networks, RNs)라는 개념을 선보였다.(논문링크)

연구팀은 "관계형 추론은 일반적으로 지능형 행동을 하기 위한 핵심 구성요소이지만 인공신경망을 학습시키는 방법으로 이를 입증하기는 어려웠다"며 "관계형 네트워크(Relation Networks, RNs)를 활용해 어떻게 이런 문제를 해결했는지를 설명한다"고 밝혔다.

■관계형 네트워크, AI 연구 새 이정표 되나

딥마인드 블로그에 따르면 관계형 추론은 예를 들어 애거서 크리스티의 추리소설을 읽고 단서들을 모아 살인범이 누군지를 예상해보거나 아이가 흐르는 공이 강물에 빠지지 않도록 그 앞을 막아서는 것, 쇼핑객들이 시장에서 키위랑 망고 중 어떤 것을 사는게 나을지를 비교해보는 일 등이다.

물리적인 사물, 문장, 추상적인 아이디어들 사이 관계를 파악해 어떤 논리적인 결론에 도달하게 하는 방식을 관계형 추론이라고 부른다.

이 회사가 새로 발표한 논문 내용만으로 이런 일들을 당장 해낼 수 있는 것은 아니다. 다만 딥러닝 분야에서 관계형 추론을 보다 효율적으로 손쉽게 구현해 의미있는 결과를 얻을 수 있다는 점을 증명해내면서 후속 연구가 기대된다.

딥마인드는 논문에서 다른 인공신경망 아키텍처에 손쉽게 추가해서 사용할 수 있는 RN 모듈을 제안했다. 마치 별다른 설정없이 PC에 외장하드디스크를 연결했다가 다시 빼는 것처럼 '플러그앤플레이(plug-and-play)' 방식을 지원한다는 설명이다.

이렇게 RN으로 강화된 인공신경망은 이미지나 일련의 문장 등과 같은 비정형 데이터를 받아들여 이들 사이 관계를 추론해낼 수 있게 된다.

■여러 사물 간 관계서 언어, 물리적 움직임까지 추론한다

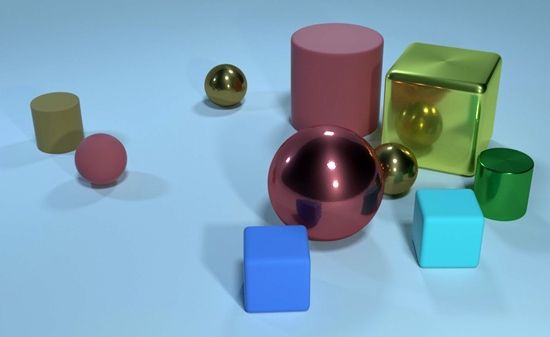

연구팀은 RN을 활용해 주어진 장면을 학습시키면 테이블 위에 여러 개 사각형, 구 등 다양한 모양으로 이뤄진 사물들 간에 관계를 추론해보는 테스트에 성공했다. 이를테면 구 모양이 사각형 보다 크기가 크다는 등 추론이 가능해진다는 설명이다.

이를 객관적으로 검증 하기 위해 연구팀은 'CLEVR'에서 RN의 성능을 테스트해봤다. CLEVR은 AI 기반 시스템이 시각 데이터를 보고 추론해 질문에 대한 정답을 내놓을 수 있는지를 테스트하기 위해 쓰이는 데이터셋이다.

"작은 고무 소재 물건이 있다. 이것은 큰 원통형 모양 물건과 색깔이 같다. 이것은 어떻게 생겼나?(There is a tiny rubber thing that is the same colour as the large cylinder; what shape is it?)"라는 등의 질문에 대해 적절한 답을 내놓을 수 있는지를 확인하는 것이다.

가장 최근 외부 연구에서 고안된 AI 아키텍처는 CLEVR을 사용한 질문에 대해 68.5%만 답변을 내놨다. 인간의 경우 92.5% 수준으로 거의 모든 질문에 답했다. 딥마인드는 논문에서 RN으로 강화된 네트워크를 쓸 경우 인간을 넘어서는 95.5% 수준으로 답변한다고 설명했다.

그렇다면 인간의 언어에 대해서는 어떨까?

연구팀은 AI 시스템이 텍스트 기반 질문에 얼마나 제대로 답변할 수 있는지를 테스트하기 위해 고안된 'babI 스위트'를 활용해 RN에 대한 검증을 시도했다.

예를 들어 "산드라가 축구공을 주웠다(Sandra picked up the football)", "산드라는 사무실에 갔다(Sandra went to the office)"라는 문장을 주고 "축구공은 어디있나?(Where is the football?)"라는 질문을 던져 사무실(office)이라는 정답을 내놓는지 확인하는 식이다.

RN으로 강화된 인공신경망은 20개 질문 데이터셋 중 18개에 대한 정답을 맞춰 95% 정답율을 보였다.

딥마인드가 공개한 또 다른 논문인 '비주얼 상호작용 네트워크(Visual Interaction Networks, VIN)'는 복잡한 인지시스템을 활용해 사물들 간 관계에 따른 물리적 상호작용을 추론해냈다.(논문링크)

이를테면 축구공을 찼을 때 인간의 뇌는 공이 벽에 부딪친 뒤 다음 어떻게 움직일지 예상한다. VIN은 RN으로 강화된 인공신경망이 이런 작업까지 수행할 수 있다는 사실을 증명했다.

딥마인드는 녹색, 파란색, 빨간색 원이 어떻게 움직이는지를 실제 시뮬레이션한 결과와 VIN을 활용해 원들의 움직임을 예측한 내용을 비교해 봤다.

그 결과 VIN은 전체 움직임 중 6 프레임만 입력값으로 줬는데 이후 일어날 원들의 움직임 중 200프레임까지 예측했다. 실제 원의 움직임을 시뮬레이션해 본 결과와 비교하니 150프레임까지 매우 유사한 움직임을 추론했다는 사실을 확인할 수 있었다.

■딥마인드 새 알고리즘, 큰 학문적 성과…후속 연구가 받쳐줘야

딥마인드가 발표한 2개 논문에 대해 미래학자 정지훈 박사는 자신의 페이스북에 올린 글에서 다음과 같이 평가했다.

"지금까지의 인공지능은 대체로 무엇(what)을 해석하거나 생성하는 것에 초점을 맞추어 왔습니다. 주어지는 문제도 그랬고, 얻을 수 있는 데이터도 대체로 그랬죠."

"그리고 그런 문제에 대해서는 이제 인간을 넘어설 수 있는 단계에 들어갔습니다. 그렇지만, 여전히 해결하지 못했던 것이 복잡한 관계를 추론하고, 이에 대한 답을 내는 것에 있어서는 인간과 비교할 수 없는 수준이었습니다."

…중략…

"그리고 현재 유행하는 딥러닝이나 통계학적 학습을 통해 관계를 파악하려던 접근 방식은 데이터가 적은 경우에는 활용자체가 어렵고, 데이터가 꽤 많이 있어도 복잡한 관계를 저치하는 데에는 근본적인 문제를 드러내고 있었습니다. 현재의 이런 문제를 깔끔히 해결한 접근방법이 바로 Relational Networks 입니다."

…중략…

"여튼 또 하나의 인공지능 기술 발전의 전기가 마련된 듯 하네요. 인공지능이 creative 한 작업을 할 수 없다는 선입견을 깬 GAN에 이어서 복잡한 관계를 파악하는 일을 인간보다 잘 할 수 있다는 RN의 등장이 한 동안 빅이슈가 될 것 같습니다."

카카오가 매월 발간하는 AI 리포트에 참여하고 있는 카카오 커뮤니케이션전략파트 김대원 박사는 "현재 AI 알고리즘은 식별에 초점이 맞춰져 있는데 딥마인드의 연구 결과는 '관계 짓기' 그리고 '추론'으로 확장됐다"며 "이론적인 관점에서 AI가 사고를 하는 존재라고 상정하면 AI 사고의 폭이 넓어진 셈"이라고 설명했다.

그는 "이 부분 때문에 이번 결과에 사람들이 크게 주목하지만 딥마인드가 개발해 낸 결과물이 구체적으로 어떤 결과로 연결될지는 조금 더 지켜봐야 할 것 같다"고 말했다.

손경호 기자(sontech@zdnet.co.kr)

Copyright © 지디넷코리아. 무단전재 및 재배포 금지.